引言

人工智能技术已经融入到各行各业,从自动驾驶、人脸识别到智能语音助手。人工智能带来了便利,但也造成了一些安全问题。一方面,攻击者使用低门槛的人工智能技术实施非法行为,造成安全问题;另一方面,由于人工智能,特别是深度神经网络本身的技术不成熟,应用人工智能技术的系统容易受到黑客攻击。

深度神经网络的技术不成熟主要在于模型的不可解释性,从模型培训到测试阶段都存在安全问题。培训阶段主要是数据中毒问题,通过在培训数据中添加一些恶意样本来误导模型的培训结果。测试阶段的安全问题主要是对抗样本。在原始样本中添加不可察觉的小干扰可以成功地欺骗分类器,导致错误的分类。

对抗样本

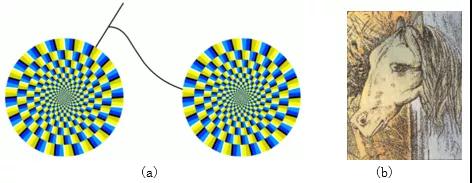

自2013年以来,深度学习模型在某些应用中已经达到甚至超过了人类水平。特别是在人脸识别、手写数字识别等任务中。随着神经网络模型的广泛应用,其不可解释的特性逐渐扩大,并出现了对抗样本。类似于人类「幻觉」,看似旋转的风车本质上是一个静止的图像(图片1a),马和青蛙的照片(图1b)。既然「幻觉」同样,对抗样本也可以欺骗神经网络。

图1 视觉幻觉图

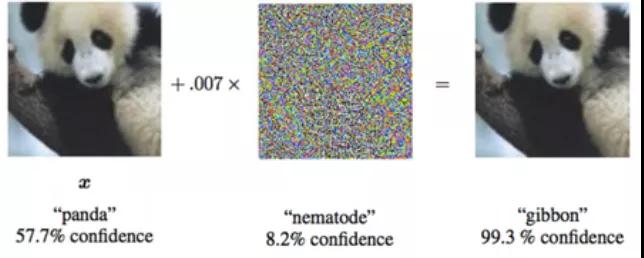

2014年,Szegedy等人[1]发现神经网络存在一些反直觉的特性,即对一张图像添加不可察觉的微小扰动后,就能使分类器误分类(图2),并将这种添加扰动的样本定义为对抗样本。理论上来说,使用深度神经网络的模型,都存在对抗样本。从此AI对抗开始成为人工智能的热点研究。

图2 对抗样本实例

应用场景

自提出对抗样本以来,研究人员特别关注神经网络的安全性。深度神经网络在各个领域都取得了显著的成就。如果神经网络本身的安全对应用程序和系统构成安全威胁,将造成巨大的损失。例如,在自动驾驶领域,停车路标误识别为限速标志,可能导致人身安全;垃圾邮件检测模型攻击后,垃圾邮件或恶意邮件不会被拦截。对抗样本的研究已经存在于图像、文本、音频、推荐系统等领域。

1.计算机视觉

(1)图像分类/识别

Szegedy第一次发现深度神经网络的对抗样本是在图像分类的背景下,在原始图像中添加一个小的像素扰动,可以导致图像分类器的误分类,这个小的扰动对人眼是不可察觉的。目前,对抗攻击在图像分类领域已经相对成熟。它不仅提出了单个图像的攻击算法,而且还提出了对任何图像的一般干扰方法,并出现了大量的攻击防御方法。

L-BFGS:2013年,Szegedy等人[1]提出L-BFGS简单的边界约束算法,找到一个与原始样本扰动距离最小的对抗样本,可以使分类器误分类。

FGSM(Fast Gradient Sign Method)[2]:算法是由的Goodfellow在预测模型本身参数的前提下,在原始图型本身参数的前提下,在原始图像的梯度下降方向上添加干扰,生成对抗样本。

JSMA(Jacobian-based saliency map attack)[3]:算法是由的Papernot等人提出的,建立在攻击者已知模型相关信息的前提下,根据分类器的结果反馈只修改输入图片中对输出影响最大的关键像素,以欺骗神经网络。

One Pixel Attack[4]:该方法于2017年提出,只需修改输入图像的像素点即可成功欺骗深度神经网络,One Pixel攻击不仅简单,而且不需要访问模型的参数和梯度信息。

C&W算法[5]:是一种基于优化的攻击方法,对抗样本与原样本之间的距离最短,攻击强度最大。该算法将原样本与对抗样本的区别结合起来作为迭代过程中的一个新的优化目标。

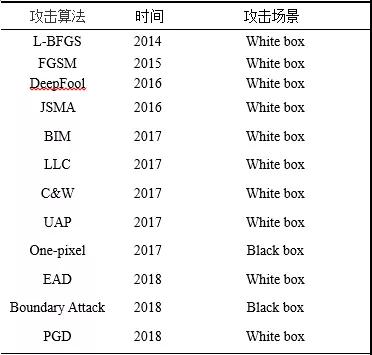

其它攻击算法包括DeepFool、UAP、BIM、PGD等待,如表1所示。

图像攻击算法表1

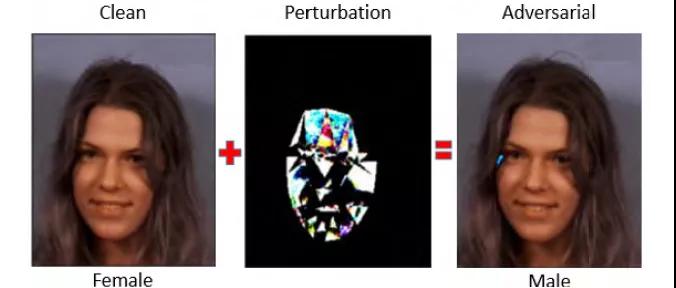

(2)人脸识别

人脸识别系统越来越广泛,其应用领域大多涉及隐私,因此人脸识别模型的安全性非常重要。2018年,Rozsa通过对抗样本中的稳定性,等人[6]探索了人脸识别中的深度学习模型“Fast Flipping Attribute”该方法生成的对抗样本攻击深度神经网络分类器发现,对抗攻击有效地改变了人脸图片中的目标属性标签。如图3所示,添加了轻微的干扰“女性”图片被人脸识别模型判别为“男性”。

图3 人脸识别对抗样本实例

(3)图像语义分割

图像语义分割是基于图像目标分类,对目标区域或像素进行分类。语义分割的对抗攻击考虑了损失函数是否可以在一组像素的基础上优化,从而产生对抗样本。Xie等人[11]提出了密度对抗生成网络,基于每个目标都需要经历一个单独的分类过程DAG,这是一种经典的语义分割和目标测试攻击方法。该方法考虑所有目标,优化整体损失函数,只需为每个目标设置对抗标签,并迭代执行梯度反向传输以获得累积干扰。

(4)目标检测

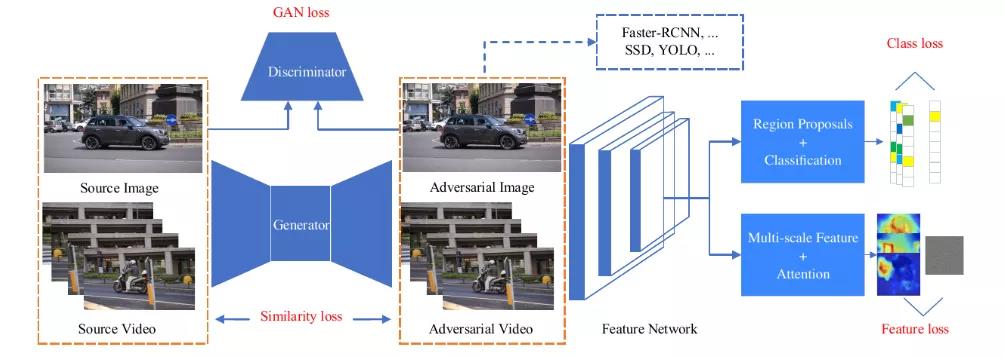

作为计算机视觉的核心任务,目标检测也受到了攻击[7]-[10]。目前,目标检测模型主要分为两类:基于提议和基于回归的模型,该机制使目标检测的对抗攻击比图像分类更复杂。文献[7]提出了一种针对两种模型可移动和高效目标检测的对抗样本生成方法UEA(图4)该方法使用条件GAN生成对抗样本,并添加多个损失函数来监督生成器的生成效果。

图4 UEA对抗攻击训练框架

(5)自动驾驶

自动驾驶汽车由多个子系统组成,包括负责场景识别、根据场景预测汽车运动和控制发动机完成汽车驾驶的子系统。目前,这三个方面逐渐采用了深度学习模型,给出了更好的决策结果,但也导致了物理场景的攻击。Evtimov等人[21]提出了物理场景对抗攻击算法RF2,各种路标识别器的识别失败。在原始路标图像上添加涂鸦或黑白块, “STOP”路标可识别为限速路标,右转路标误识别为“STOP”路标或添加车道路标。

图5 路标对抗样本

2.自然语言处理

自然语言处理是除计算机视觉外人工智能应用最广泛的领域之一,因此人工智能本身的脆弱性也会导致自然语言处理任务的安全风险。然而,与计算机视觉中对图像的攻击不同,自然语言处理领域操作文本序列数据,主要困难在于:①图像是一个连续的数据,它仍然可以通过扰动一些像素来保持图像的完整性,而文本数据是离散的,任何添加字符或单词都会导致句子缺乏语义信息;②图像像素的轻微干扰对人眼是不可察觉的,文本的轻微变化很容易被察觉。目前,自然语言处理在情感分类、垃圾邮件分类、机器翻译等领域发现了对样本的攻击[12]-[15]除了改进计算机视觉中的攻击算法外,文本领域还提出了一些新的攻击算法。

(1)文本分类

在情感分析任务中,根据每个影评中的单词,分类模型是积极或消极的。然而,如果某些单词在消极句子中被打扰,情感分类模型将被误分为积极情绪。Papernot等人[13]将计算机视觉领域JSMA算法迁移到文本领域,利用计算图扩展技术评估与单词序列嵌入输入相关的前导数,构建优雅的可比矩阵,并从中学习FGSM对抗扰动的思想计算。

图6 情感分析任务中的对抗样本

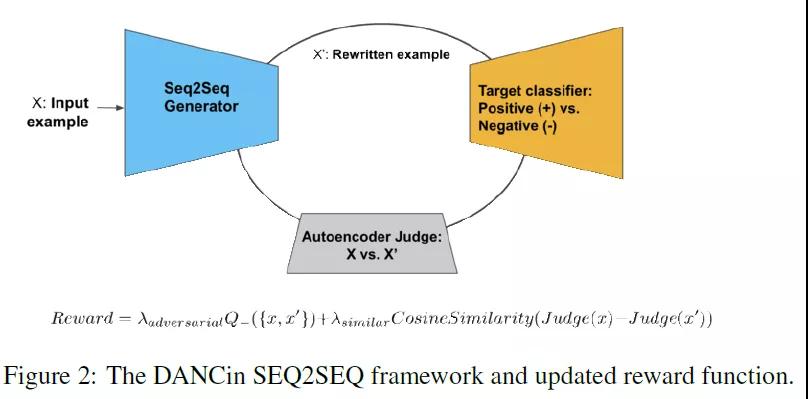

在垃圾邮件分类任务中,如果模型受到抗样本攻击,垃圾邮件发布者可以绕过模型拦截。文献[16]提出了一个基础GAN为了解决对抗样本的生成方法GAN不能直接应用于离散文本数据的问题,并提出增强学习任务(REINFORCE)奖励可以满足目标判别器误分类和语义相似的对抗样本。

图7 基于加强学习GAN

(2)机器翻译/文本摘要

不同于文本分类任务输出空间有限,机器翻译任务输出空间无限。Cheng等人[15]提出了一种针对性seq2seq模型的对抗样本生成方法提出了离散输入空间带来的问题的结合group lasso而梯度正则化的投影梯度法,针对输出空间是序列数据的问题,设计了新颖的损失函数,实现目标关键字攻击。

3.网络安全

深度学习模型自动检测威胁情报已广泛应用于网络安全领域。如果将对抗攻击转移到对安全更敏感的应用程序中,如恶意软件检测,这可能会对样本生成提出重大挑战。同时,失败可能会给网络留下严重的漏洞。目前,对抗攻击已在恶意软件检测、入侵检测等方进行了对抗研究[16]-[18]。

(1)恶意软件检测

相较于之前的计算机视觉问题,恶意软件应用场景有如下限制:①输入不是连续的,而是离散的,通常是二分数据;②不受约束的视觉不变性需要用相同的函数代替。Grosse等人[16]验证了恶意软件识别领域对抗攻击的可行性,用二进制特征向量表示恶意软件,并借鉴Papernot等人[13]采用JSMA实验证明,对抗攻击确实存在于恶意软件探测领域。

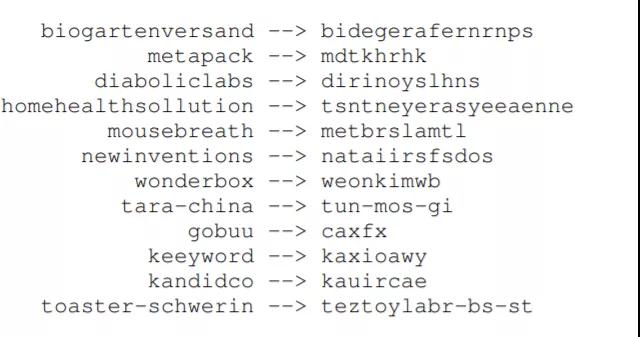

(2)恶意域名检测

恶意域名DGA由于家庭变化频繁,伪装好,机器学习模型在识别阶段鲁棒性不高。Hyrum等人[17]提出了一个基础GAN生成恶意域名样本的方法DeepDGA,使用生成的恶意域名进行对抗训练来增强机器模型DGA结果表明,域名家族的识别准确性是由GAN恶意域名可以成功避免随机森林分类器的识别,并在对抗样本训练后加入随机森林DGA家庭识别的准确性明显高于对抗训练。

图8 DeepDGA恶意域名

(3)DDoS攻击

在DDoS攻击领域,Peng等人[18]提出了改进的边界攻击方法生成DDoS通过迭代修改输入样本,攻击对抗样本接近目标模型的决策边界。

4.语音识别

目前,语音识别技术的着陆场景较多,如智能扬声器、智能语音助手等。虽然语音识别技术发展良好,但由于深度学习模型本身的脆弱性,语音识别系统不可避免地受到对抗样本的攻击。2018年,伯克利人工智能研究员Carlini 和Wagner发明了一种新的语音识别攻击方法,这也是第一次攻击语音识别系统,通过产生原始音频的基线失真噪声来构建对抗音频样本,可以欺骗语音识别系统产生任何攻击者想要的输出[19]。

5.推荐系统

在推荐系统领域,如果攻击推荐模型,下一个推荐item将是人工广告。基于协同过滤(CF)由于其良好的性能和推荐因素,潜在因素模型已广泛应用于现代推荐系统。但事实表明,这些方法很容易受到对抗攻击的影响,导致不可预测的伤害推荐结果。目前,推荐系统中常用的攻击方法是基于计算机视觉的攻击算法FGSM、C&W、GAN等[20]。目前,该领域的对抗攻击仍存在挑战:①由于推荐系统的预测依赖于一组实例而不是单个实例,因此可能会产生瀑布效应,对单个用户的攻击可能会影响相邻用户;②与图像的连续数据相比,推荐系统的原始数据是离散用户/项目ID等级,直接干扰离散的实体会改变输入数据的语义信息。如何保持推荐系统对样本的视觉不可见性仍有待解决。

小 结

目前,该领域有许多研究方向和攻击算法。提出攻击算法后,将出现一种防御方法,然后对防御方法提出新的攻击方法。然而,在类似的攻击和防御周期中,仍然缺乏有效的评估方法来判断攻击是否有效。此外,一些领域存在对抗攻击,但尚未研究和发现。

参考文献…

[1] Szegedy C,Zaremba W,Sutskever I,et al. Intriguing properties of neural networks[J]. arXiv preprint arXiv:1312.6199,2013.

[2] I. Goodfellow,J. Shlens,C. Szegedy. Explaining and Harnessing Adversarial Examples[C]. ICLR,2015.

[3] N. Papernot,P. McDaniel,S. Jha,M. Fredrikson,Z. B. Celik,A. Swami. The Limitations of Deep Learning in Adversarial Settings[C]// Proceedings of IEEE European Symposium on Security and Privacy. IEEE,2016.

[4] J. Su,D. V. Vargas,S. Kouichi. One pixel attack for fooling deep neural networks[J]. IEEE Transactions on Evolutionary Computation,2017.

[5] N. Carlini,D. Wagner. Towards Evaluating the Robustness of Neural Networks [C]// Proceedings of IEEE Symposium on Security and Privacy (SP). IEEE, 2017: 39-57.

[6] Rozsa A,Günther M,Rudd E M,et al. Facial attributes: Accuracy and adversarial robustness[J]. Pattern Recognition Letters,2019,124: 100-108.

[7] Wei X,Liang S,Chen N,et al. Transferable adversarial attacks for image and video object detection[J]. arXiv preprint arXiv:1811.12641,2018.

[8] Cihang Xie,Jianyu Wang,Zhishuai Zhang,Yuyin Zhou,Lingxi Xie,and Alan Yuille. Adversarial examples for semantic segmentation and object detection.

[9] Shang-Tse Chen,Cory Cornelius,Jason Martin,and Duen Horng Chau. Robust physical adversarial attack on faster r-cnn object detector. arXiv preprint arXiv:1804.05810,2018.

[10] Yuezun Li,Daniel Tian,Xiao Bian,Siwei Lyu,et al. Robust adversarial perturbation on deep proposal-based models. arXiv preprint arXiv:1809.05962, 2018.

[11] Xie C,Wang J,Zhang Z,et al. Adversarial examples for semantic segmentation and object detection[C]//Proceedings of the IEEE International Conference on Computer Vision. 2017: 1369-1378.

[12] J. Li,S. Ji,T. Du,B. Li,and T. Wang,“Textbugger: Generating adversarial text against real-world applications,” in the Network and Distributed System Security Symposium,2019.

[13] Nicolas Papernot,Patrick McDaniel,Ananthram Swami,and Richard Harang. 2016. Crafting Adversarial Input Sequences for Recurrent Neural Networks. In Military Communications Conference(MILCOM). IEEE,2016: 49–54

[14] Wong C. Dancin seq2seq: Fooling text classifiers with adversarial text example generation[J]. arXiv preprint arXiv:1712.05419,2017.

[15] Cheng M,Yi J,Chen P Y,et al. Seq2Sick: Evaluating the Robustness of Sequence-to-Sequence Models with Adversarial Examples[C]//AAAI. 2020: 3601-3608.

[16] Grosse K,Papernot N,Manoharan P,et al. Adversarial perturbations against deep neural networks for malware classification[J]. arXiv preprint arXiv:1606.04435,2016.

[17] Anderson H S,Woodbridge J,Filar B. DeepDGA: Adversarially-tuned domain generation and detection[C]//Proceedings of the 2016 ACM Workshop on Artificial Intelligence and Security. 2016: 13-21.

[18] Peng X,Huang W,Shi Z. Adversarial Attack Against DoS Intrusion Detection: An Improved Boundary-Based Method[C]//2019 IEEE 31st International Conference on Tools with Artificial Intelligence (ICTAI). IEEE,2019: 1288-1295.

[19] Carlini N,Wagner D. Audio adversarial examples: Targeted attacks on speech-to-text[C]//2018 IEEE Security and Privacy Workshops (SPW). IEEE,2018: 1-7.

[20] Deldjoo Y,Di Noia T,Merra F A. Adversarial Machine Learning in Recommender Systems: State of the art and Challenges[J]. arXiv preprint arXiv:2005.10322,2020.

[21] Eykholt K,Evtimov I,Fernandes E,et al. Robust physical-world attacks on deep learning visual classification[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2018: 1625-1634.

【本文为51CTO专栏作者“中国保密协会科学技术分会”请联系原作者转载原稿

戳这里,看作者更好的文章